Involvierte Definitionen:Veranstaltung: EMLReferenz: @thimm2024 (Abschnitt 5.1.5)

⠀

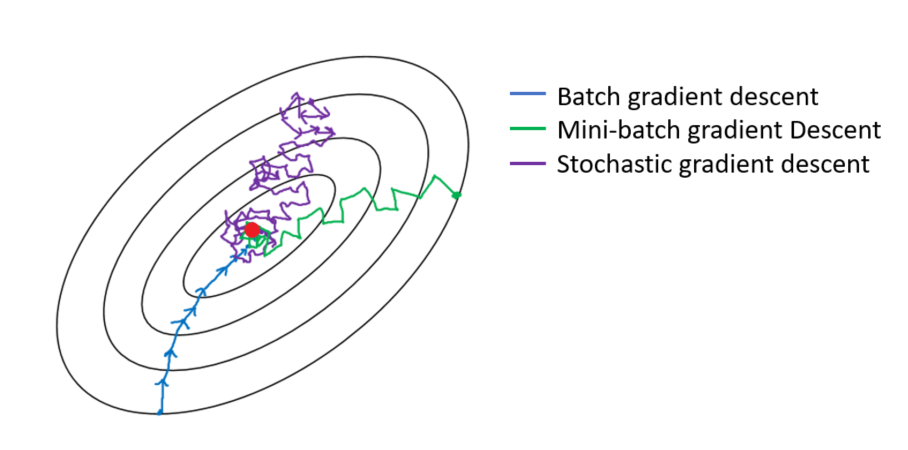

Proposition: Gradient Descent vs Stochastic Gradient Descent vs Mini-Batch Gradient Descent

Illustrativ führen wir beim (Batch-) Gradient Descent sehr genaue Schritte durch, dafür ist deren Berechnung aber sehr rechenintensiv.

Beim Stochastic Gradient Descent führen wir sehr ungenauere Schritte durch - dafür sind sie aber sehr schnell zu berechnen, weshalb wir viele Schritte durchführen können.

Der Mini-Batch Gradient Descent ist ein Mix aus beiden Ansätzen: