Generalisierungen:Eigenschaften:Involvierte Definitionen:Veranstaltung: EMLReferenz: @thimm2024 (Abschnitt 5.1.3)

⠀

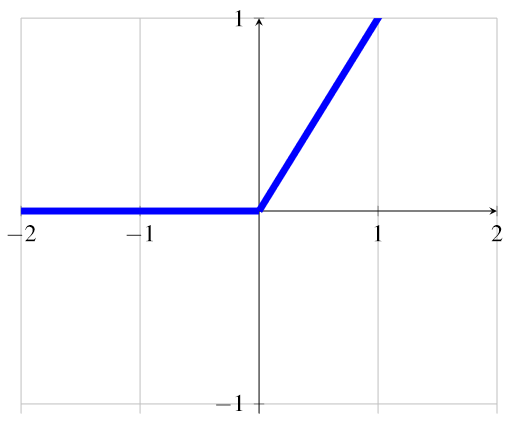

Definition: ReLU-Aktivierungsfunktion

Als Rectified Linear Unit (kurz ReLU, de. Gleichrichter) bezeichnen wir eine Aktivierungsfunktion, die in neuronalen Netzen verwendet wird.

Die ReLU-Funktion hat den Vorteil, dass sie einfach zu berechnen ist, dass ihre Ableitung (mit Ausnahme der Unstetigkeit in

) leicht zu berechnen ist und das Problem der verschwindenden Gradienten mindert, was das Training tiefer neuronaler Netzwerke erleichtert. Die folgende Illustration zeigt den Graphen der ReLU-Aktivierungsfunktion: