Konstrukte:Generalisierungen:Eigenschaften:Involvierte Definitionen:- MapReduce

- HDFS

- siehe auch Apache Spark

Veranstaltung: DEDSReferenz: @storl2024 (KE5, Analyse von Big Data; Teil 2)

⠀

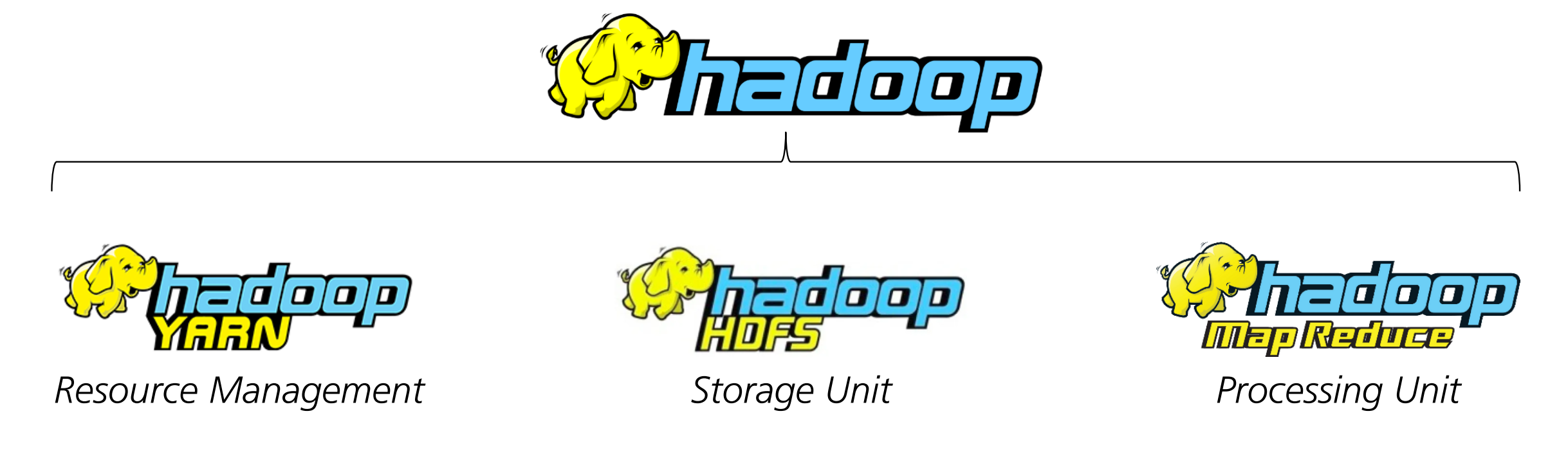

Definition: Hadoop

Apache Hadoop ist ein Open-Source-Framework, das zur Speicherung und Verarbeitung großer Datenmengen (Petabytes) in verteilten Rechnerumgebungen dient.

Hadoop ermöglicht es, diese Datenmengen effizient zu analysieren und zu verarbeiten, indem es die Arbeit auf mehrere Computercluster verteilt.

Hierzu verwendet es das Hadoop Distributed File System (HDFS) für die Datenspeicherung und das MapReduce-Programmiermodell zur Datenverarbeitung.

Anmerkung

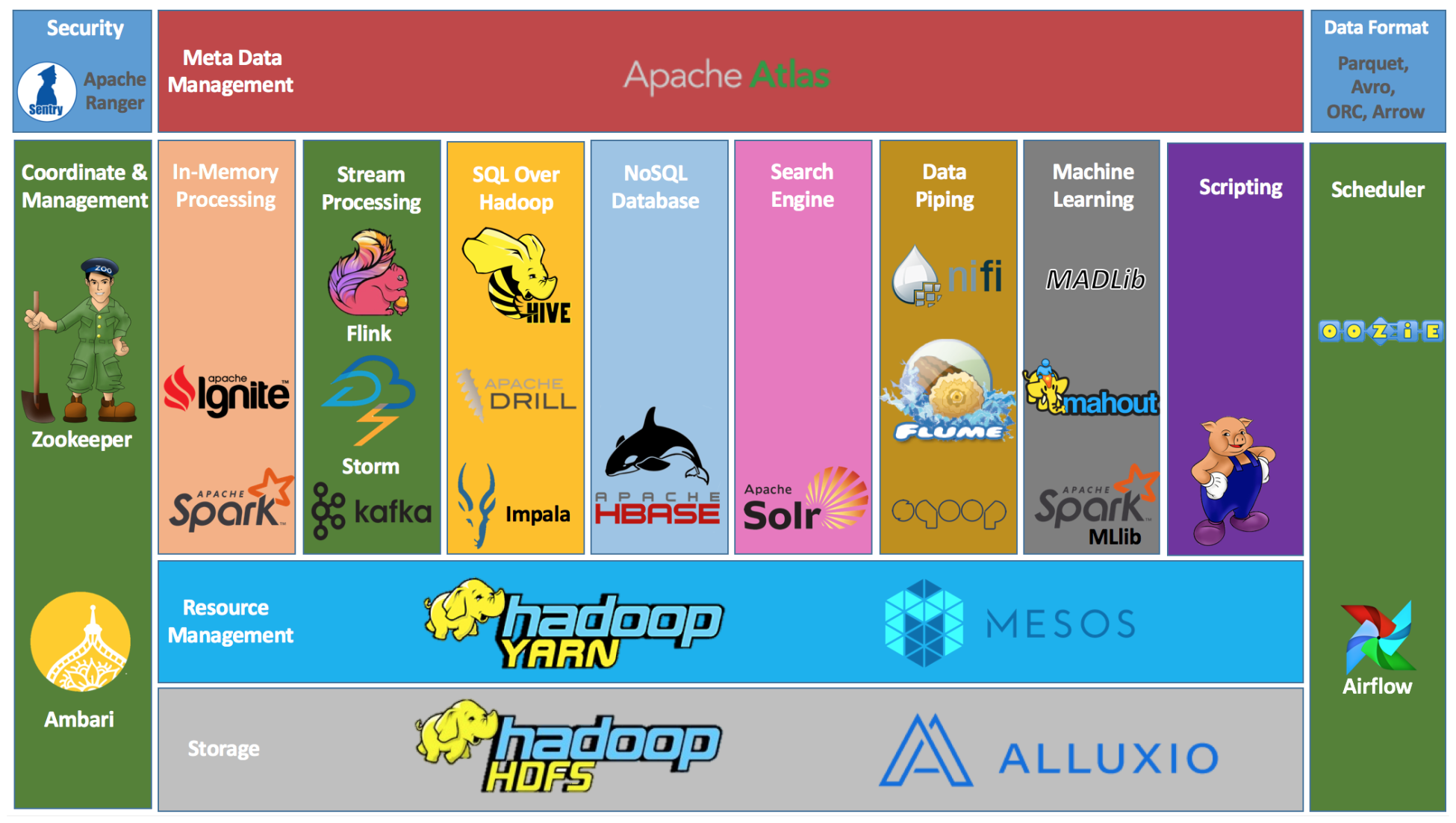

Hadoop Ökosystem

Eine Stärke von Hadoop ist das mittlerweile recht umfangreiche Ökosystem:

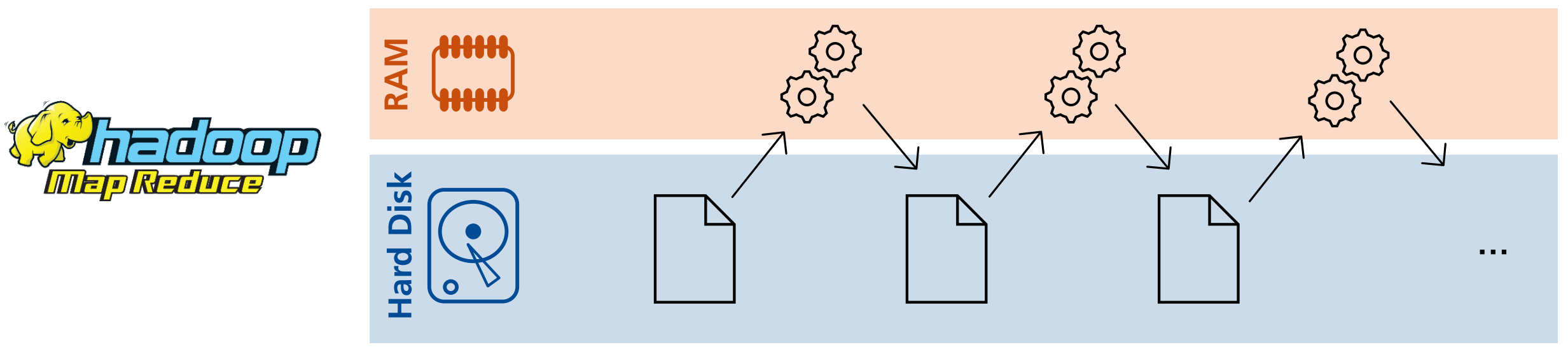

Probleme von Hadoop

Ein zentraler Kritikpunkt von Hadoop ist die Performance.

Der MapReduce-Layer erstellt nach jedem Schritt eine neue Datenkopie und persistiert diese. Die ständigen Read/Write Operationen machen das System langsamer:

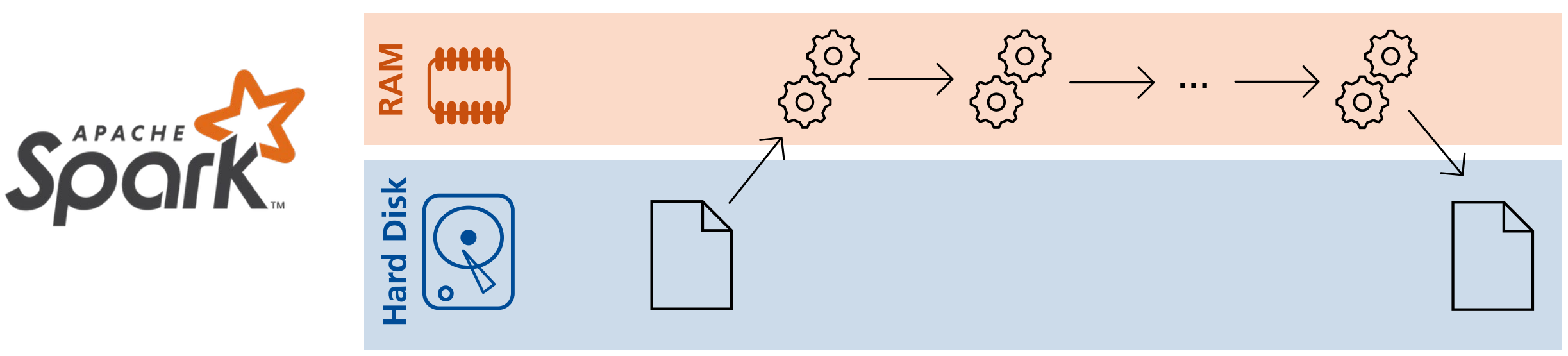

Eine Alternative zu dem MapReduce-Layer von Hadoop stellt Apache Spark dar. In Spark werden die Daten erst nach Abschluss aller Map-Schritte persistiert: