Konstrukte:Eigenschaften:Involvierte Definitionen:Veranstaltung: DEDSReferenz: @storl2024 (KE5, Analyse von Big Data; Teil 2)

⠀

Definition: HDFS

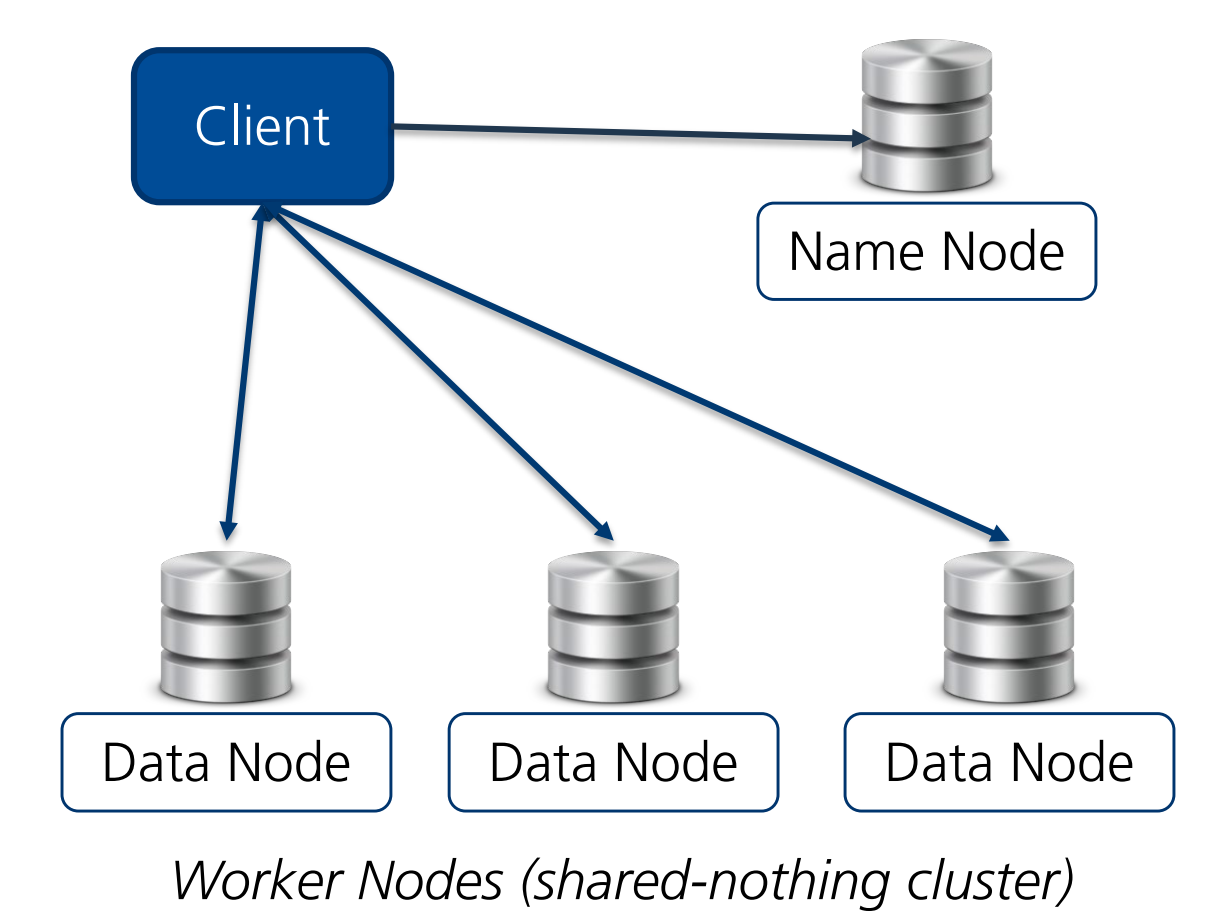

Als Hadoop Distributed File System (kurz HDFS) bezeichnen wir ein Java-basiertes verteiltes Dateisystem, das für die Speicherung und Verwaltung großer Datenmengen (Petabytes) entwickelt wurde.

Es ermöglicht eine zuverlässige, skalierbare und kostengünstige Datenverarbeitung, indem es Daten in Blöcken (default: 128MB) auf mehrere Worker Nodes (auch Data Nodes) verteilt und redundante Kopien (default: 3x) zur Ausfallsicherheit erstellt.

Die Verwaltung der Worker/Data Nodes geschieht durch einen oder mehrere Name Nodes.