Beispiele:Generalisierungen:Involvierte Definitionen:Veranstaltung: EDSReferenz:- @beecks2024 (LE1 und LE3)

- @stodden2020

- The preregistration revolution, Nosek et al.

- siehe auch Data Science Process Alliance

⠀

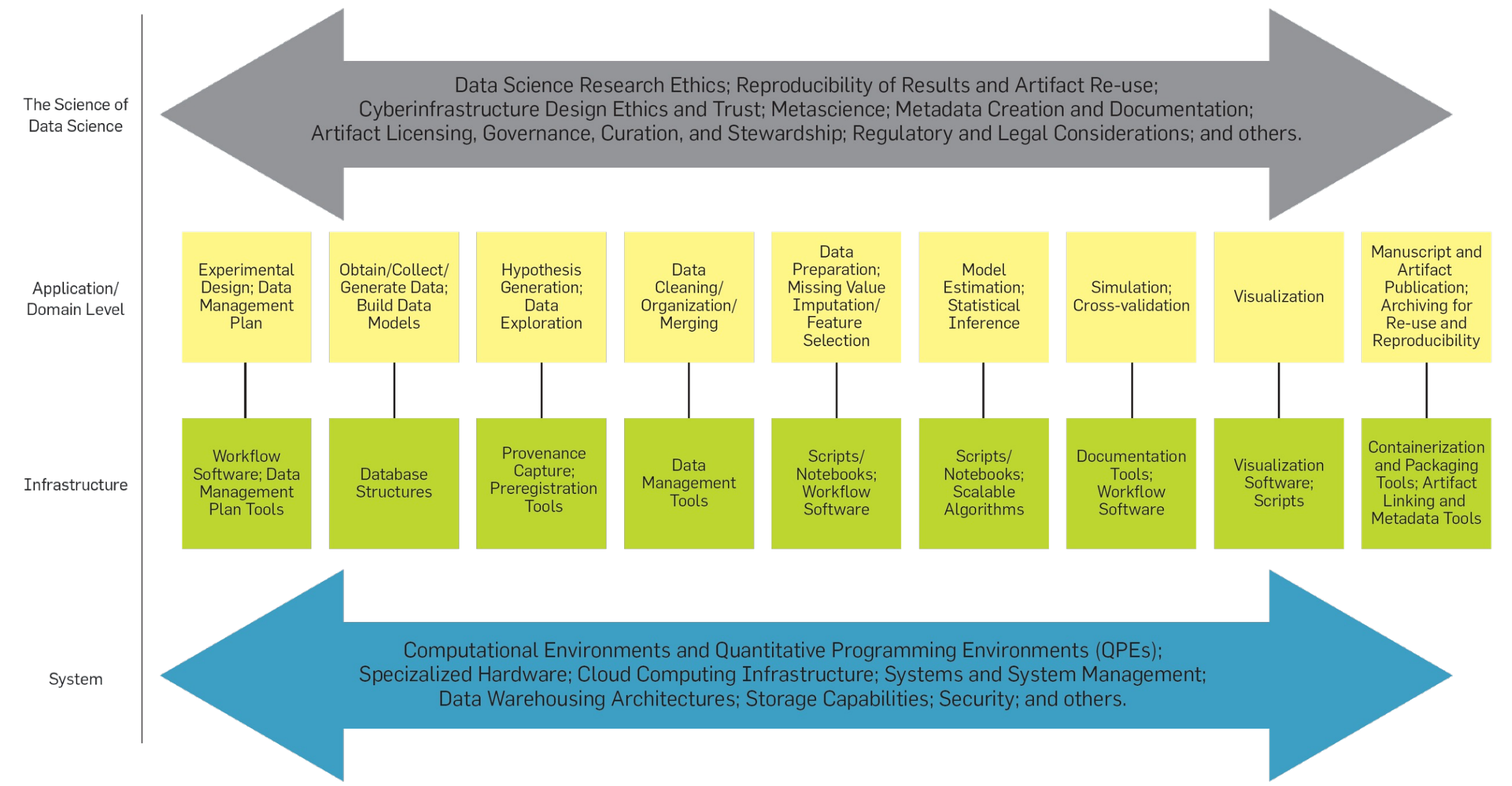

Definition: Data Science Life Cycle

Der Data Science Life Cycle von @stodden2020 ist ein Vorgehensmodell für die Durchführung von Projekten der Data Science.

Er definiert zwar die durchzuführenden Schritte, macht jedoch keine Angaben über konkrete Methoden zur Durchführung der Schritte. Er ist also lediglich eine Hülle, die individuell gefüllt werden muss.

Achtung: Die einzelnen Schritte sind nicht unbedingt als Wasserfall zu verstehen.

Definition: Metawissenschaftliche Ebene

Die metawissenschaftliche Ebene des Data Science Life Cycles beschäftigt sich mit den Fragen:

- Wie wird mit Erkenntnissen und Artefakten (Daten, Quelltext, Domänenwissen, …) umgegangen?

- Wie wird Wieder- und Weiterverwendung sichergestellt?

- Welche rechtlichen/ethischen Fragestellungen sind zu beachten?

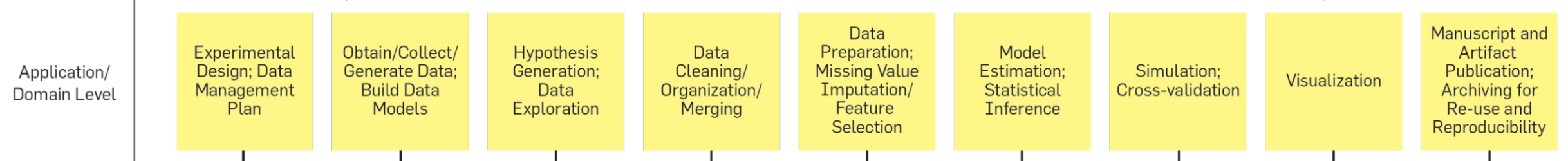

Definition: Anwendungsebene

Die Anwendungsebene innerhalb des Data Science Life Cycles umfasst die Schritte eines Forschungsprojekts, die von der Domäne geleitet werden.

Er umfasst:

- Experimentelles Design und Daten Management Plan

- Code Repository,

- Daten Repository (DVC, Datenbank, …),

- rechtliche Anforderungen an die Daten

- Gestaltung des Datenmodells

- Welche Art von Daten?

- Wie hängen die Daten miteinander zusammen?

- semantische Ebene (Kamera),

- logische Ebene (Matrix)

- und physische Ebene (Data Lake)

- Datenexploration/Hypothesengenerierung

- Attribute und Werte betrachten,

- explorative Visualisierung

- Datenaufbereitung und Bereinigung

- Behandlung fehlender Daten und Feature-Selektion

- Modellerstellung

- Validierung des Modells/Simulation

- Visualisierung

- Daten

- Statistische Kennzahlen

- Erkenntnisse

- Modell / Performance

- Kommunikation der Ergebnisse

- Publikationen

- Softwareprototyp

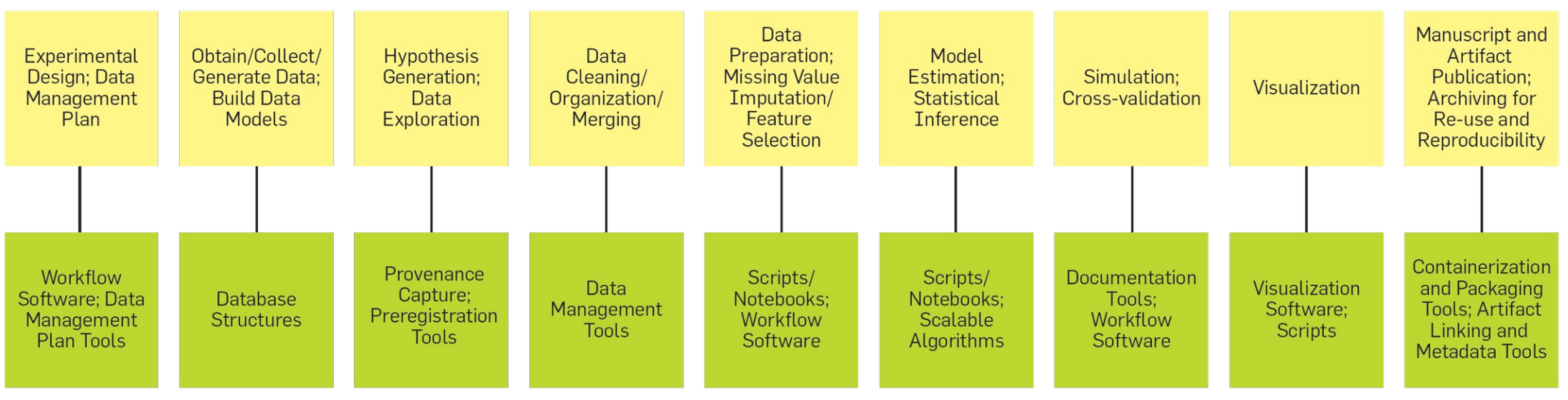

Definition: Infrastrukturebene

Die Infrastrukturebene des Data Science Life Cycles umfasst die Schritte:

- Workflow Software; Tools für das Verfassen des Datenmanagementplans,

- Datenbankstruktur (SQL, NoSQL, Excel, Access, CSV, …)

- Provenance Capture (Aufzeichnung der Herkunft und Verarbeitungsverlaufes der Daten) und Preregistration Tools (Verfahren zur Unterscheidung von explorativer und konfirmatorischer Forschung)

- Data Management Tools,

- Software Entwicklungstools

- Dokumentationstools

- Visualisierungssoftware

- Containerisierung und Artefakt-Verknüpfung

Definition: Systemebene

Die Systemebene des Data Science Life Cycles beschäftigt sich mit den Fragen:

- Welche Hardwareanforderungen (CPU, RAM, GPU, SSD) haben wir?

- Wo werden die Daten gespeichert? (Edge, Cloud, On Prem)

- Wo werden die Berechnungen durchgeführt? (Edge, Cloud, On Prem Kubernetes)

- Sicherheit der Daten und Ergebnisse bei Übertragung, Verarbeitung, Speicherung?