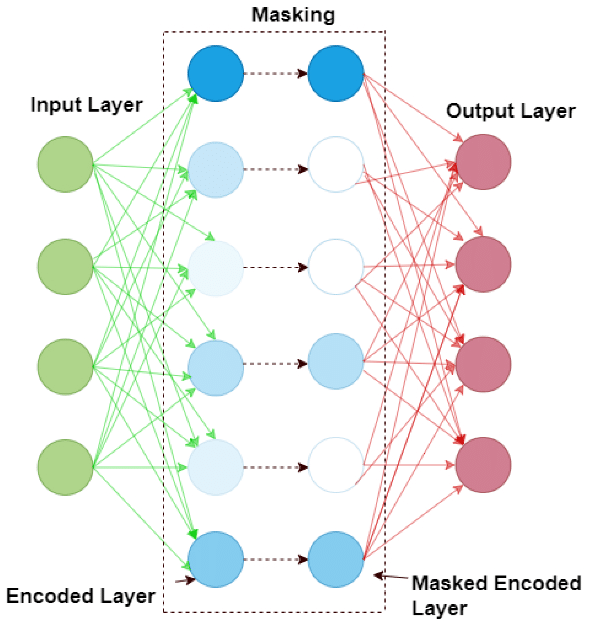

Typen:- DAE, wenn Masking betrieben wird, statt eine Gauß-Verteilung hinzuzufügen

Generalisierungen:Involvierte Definitionen:Veranstaltung: EMLReferenz: @thimm2024 (Abschnitt 5.4)

⠀

Definition: Sparse Autoencoder

Als Sparse Autoencoder (kurz SAE) bezeichnen wir eine Variante des Autoencoders, die darauf abzielt, eine latente Repräsentation zu lernen, bei der nur eine geringe Anzahl der Neuronen aktiviert wird.

Dies wird durch Hinzufügen einer Sparsity-Bedingung während des Trainings erreicht, durch die die Aktivierungen der meisten Neuronen in der Bottleneck-Schicht inaktiv (d.h. nahe Null) bleiben.

Bei dieser Sparsity-Bedingung kann es sich beispielsweise um eine L2-Regularisierung handeln. Die Fehlerfunktion erhalten wir also durch:

wobei

der Encoder, der Decoder und der Regularisierungsparameter seien. In der Regel handelt es sich bei SAEs um overcomplete-Autoencoder, deren “Bottleneck”-Schicht mehr Neuronen enthält, als die Ein- und Ausgabe Schichten, also

.

Footnotes

-

Sparse AE durch Masking statt L2-Regularisierung: Dhengre, Sinha, 2022 ↩