Generalisierungen:Involvierte Definitionen:Veranstaltung: EMLReferenz: @thimm2024 (Abschnitt 5.1.3)

⠀

Definition: Softplus-Aktivierungsfunktion

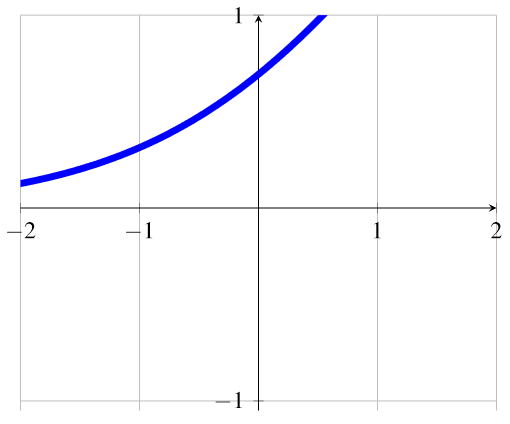

Als Softplus-Aktivierungsfunktion definieren wir eine glatte und differenzierbare Annäherung an die ReLU-Funktion:

Sie gibt positive Werte für alle Eingaben zurück und ist besonders nützlich, da sie keine abrupten Übergänge wie die ReLU-Funktion aufweist, was sie robuster gegenüber kleinen Änderungen der Eingabe macht. Ihr Gradient ist außerdem stets größer als

. Die folgende Illustration zeigt den Graphen der Softplus-Aktivierungsfunktion: