Involvierte Definitionen:Veranstaltung: DEDSReferenz: @storl2024 (KE5, Analyse von Big Data; Teil 4)

⠀

Definition: RDD Caching

Wie in der Notiz zu Spark dargestellt, werden Operationen auf RDDs im Standard nicht gecacht.

Das bedeutet: jede weitere Trigger-Action führt alle Operationen des zugrundeliegenden Lineage-Graphen erneut aus.

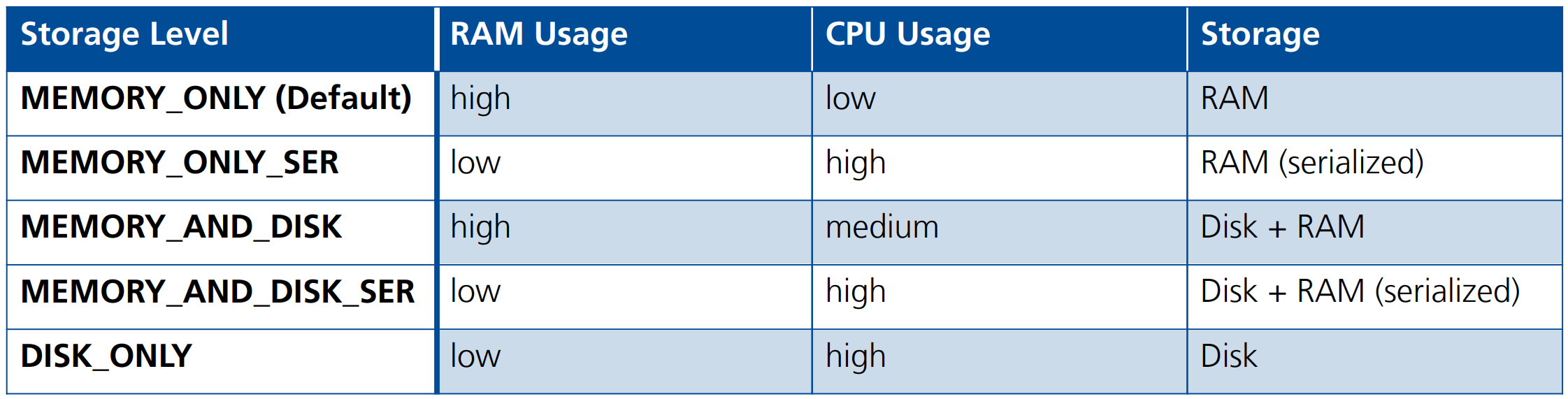

Mithilfe der

.cache()-Funktion können wir jedoch angeben, welche Zwischenergebnisse gecacht werden sollen - und welcher Cache genutzt wird:

Der Garbage-Collector von Spark überprüft die Speicherlast regelmäßig und löscht Daten nach dem Least-Recently-Used (LRU)-Prinzip.

Anmerkung

Caching in Python

In Python werden die Daten immer mit Pickle serialisiert und abgespeichert.