Konstrukte:Involvierte Definitionen:Veranstaltung: EMLReferenz:

⠀

Definition: Weighted Cross-Entropy-Loss für

Klassen Den gewichteten Cross-Entropy-Loss für

Klassen erhalten wir durch: wobei:

: Anzahl der Klassen, , wenn das aktuelle Beispiel zu der -ten Klasse gehört, sonst. : Die vorhergesagte Wahrscheinlichkeit für die -te Klasse. : Hyperparameter zum Ausgleich eines Klassenungleichgewichts. Hat die -te Klasse bspw. Instanzen, so könnten wir setzen (Inverse Klassenhäufigkeit, eng. inverse class frequency).

Definition: Focal Loss für

Klassen Den Focal Loss für

Klassen erhalten wir durch: wobei:

: Focusing Parameter. Je größer , desto schwächer zählen Beispiele zum Loss hinzu, die schon mit hoher Wahrscheinlichkeit korrekt vorausgesagt werden. Für sind Focal Loss und Cross Entropy Loss identisch - Die anderen Parameter sind identisch zum Cross Entropy Loss.

Was hat es mit

und auf sich?

und werden hier genutzt, um zwischen Positiv- und Negativbeispielen zu unterscheiden.

- Haben wir in dem Beispiel die

-te Klasse beobachtet, so ist und . Wir betrachten also nur den ersten Teil des Losses. - Haben wir in dem Beispiel nicht die

-te Klasse beobachtet, so ist und . Wir betrachten also nur den zweiten Teil des Losses.

Anmerkung

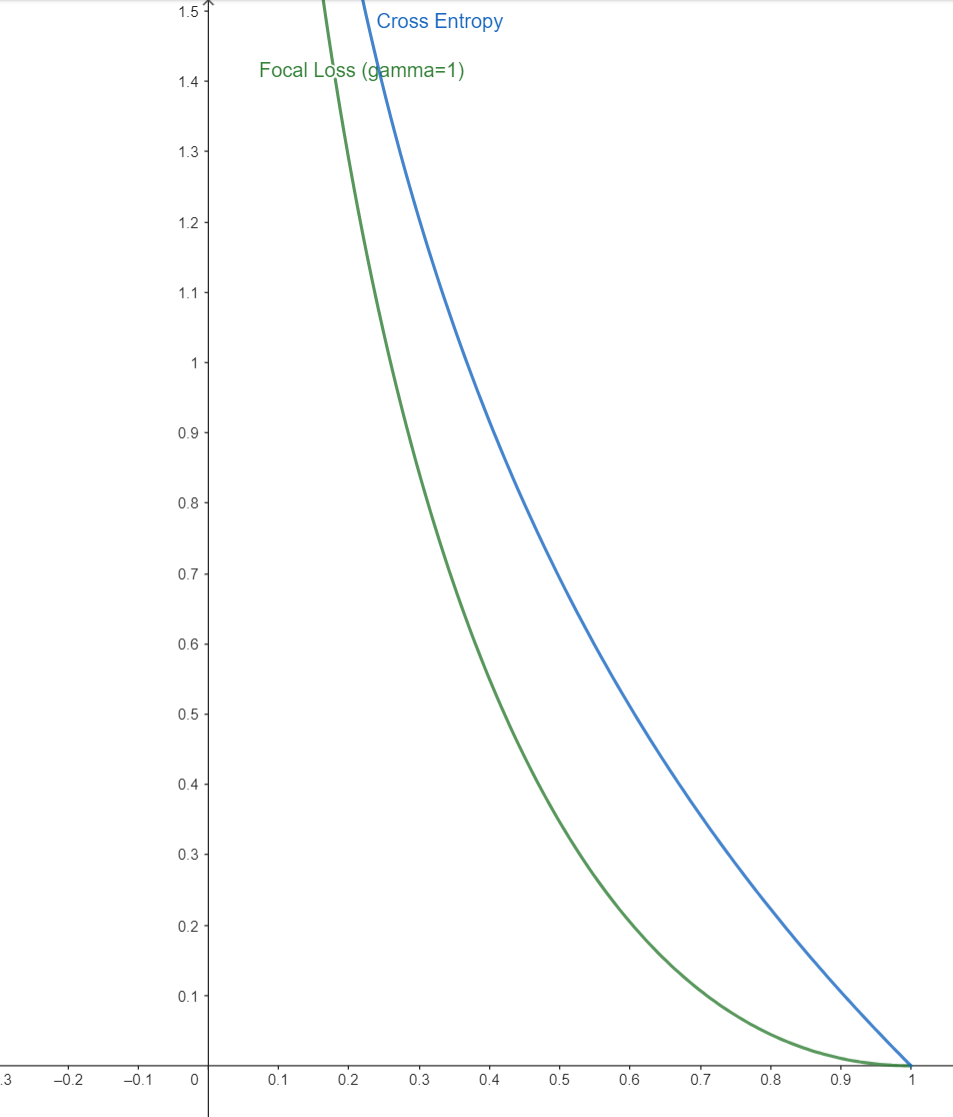

Illustration - Focal Loss vs. Cross Entropy Loss

An der Illustration (hier am Beispiel

) kann man gut sehen, dass der Focal Loss (für gute Vorhersagen von , also ) schneller gegen geht, als der Cross Entropy Loss.