Konstrukte:Involvierte Definitionen:Veranstaltung: DS4DH, IRReferenz: @wagenpfeil2024 (p. 5 ff.)

⠀

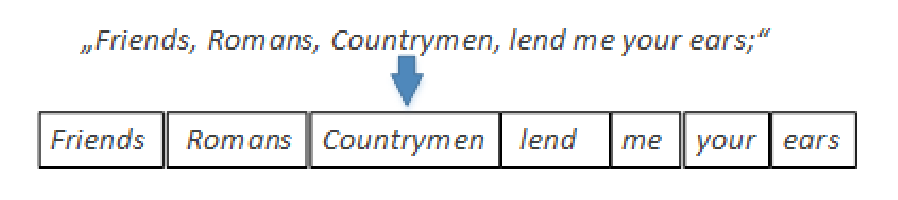

Definition: Tokenization

Als Tokenization bezeichnen wir den Prozess der Aufteilung von Text in seine semantisch zusammengehörigen Einheiten (Tokens) und zusätzlich die Entfernung nicht benötigter Satzzeichen.

Die Tokenization ist sprachabhängig, da sich die Regeln zur Wortbildung, Zeichensetzung und Bedeutung von Verbindungen zwischen Sprachen unterscheiden:

- Englisch: “state-of-the-art” kann als ein einzelnes Token oder als mehrere Tokens („state”, „of”, „the”, „art”) behandelt werden, während „co-occurrence” sinnvollerweise als ein Token erhalten bleibt.

- Französisch: Bindestrichverbindungen wie „quatre-vingts” oder „non-fumer” werden meist als ein Token betrachtet. Apostrophkonstruktionen wie „l’ensemble” oder „c’est” müssen erkannt und korrekt zusammengeführt werden.

- Deutsch: Lange Komposita wie „Donaudampfschifffahrtsgesellschaftskapitän” werden häufig in ihre Bestandteile zerlegt (“Donau”, “Dampf”, “Schifffahrt”, “Gesellschaft”, “Kapitän”), um eine präzisere Indexierung zu ermöglichen.

Im Rahmen der Tokenization können Stoppwörter (z. B. “der”, “und”, “the”) entfernt werden, da sie meist keine relevante Bedeutung für die Dokumentidentifikation tragen.

Durch das Entfernen solcher Wörter können jedoch sinntragende Phrasen oder Relationen verloren gehen. etwa bei Suchanfragen wie “King of Scotland”, “to be or not to be” oder “flights to London”.

Einige Verfahren verzichten daher auf Stoppwortlisten.